Logical Chain-of-Thought (LogiCoT) Prompting

Logický myšlenkový řetězec (LogiCoT) je zaměřen na zlepšení schopnosti nulového uvažování velkých jazykových modelů (LLM) začleněním principů ze symbolické logiky.

Metodika LogiCoT zahrnuje dvojí proces:

- za prvé, použití reductio ad absurdum k identifikaci a opravě logických chyb v rámci argumentačního řetězce;

- za druhé, strukturování procesu uvažování, které umožňuje systematické ověřování a revizi každého argumentačního kroku na základě logických principů.

Tento proces je doplněn zavedením mechanismu růstu řetězce, který selektivně reviduje nepravděpodobné kroky uvažování, čímž zvyšuje přesnost uvažování modelu bez zbytečné výpočetní zátěže.

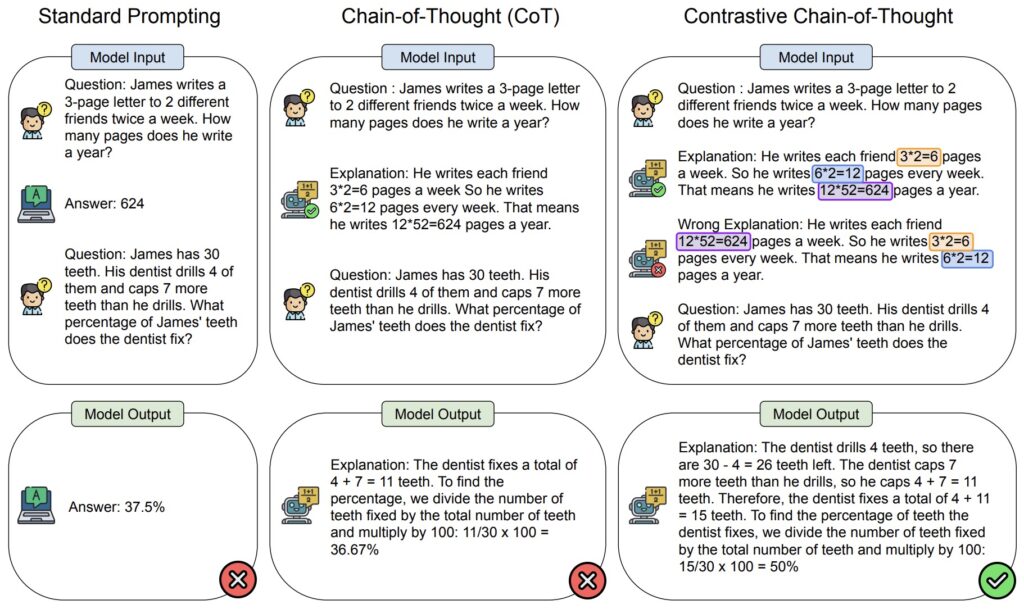

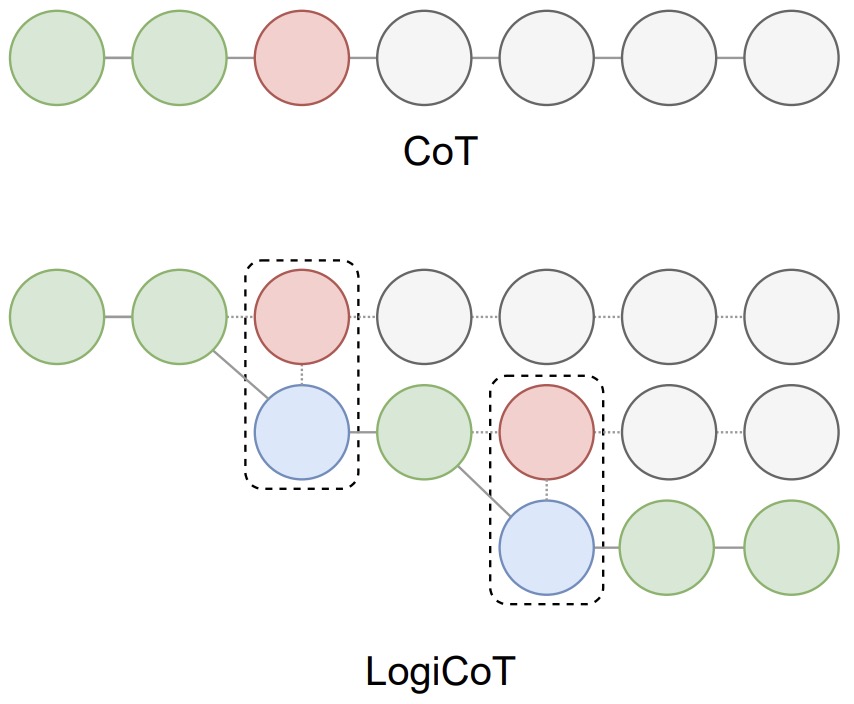

Na obrázku níže je znázorněn přehled podnětů myšlenkového řetězce (CoT) a LogiCoT. V případě CoT činí selhání entailmentu (červeně) zbytek dedukce nedůvěryhodným (šedě), což v důsledku brání celkovému úspěchu dedukce. Naproti tomu LogiCoT je navržen tak, aby myslel-ověřoval-revidoval: přijímá ty, které projdou ověřením (zeleně), a reviduje (modře) ty, které neprojdou, čímž efektivně zlepšuje celkovou schopnost usuzování.

Speciální triky pro pokročilé

Speciální triky pro pokročilé