Promptování založené na gradientu

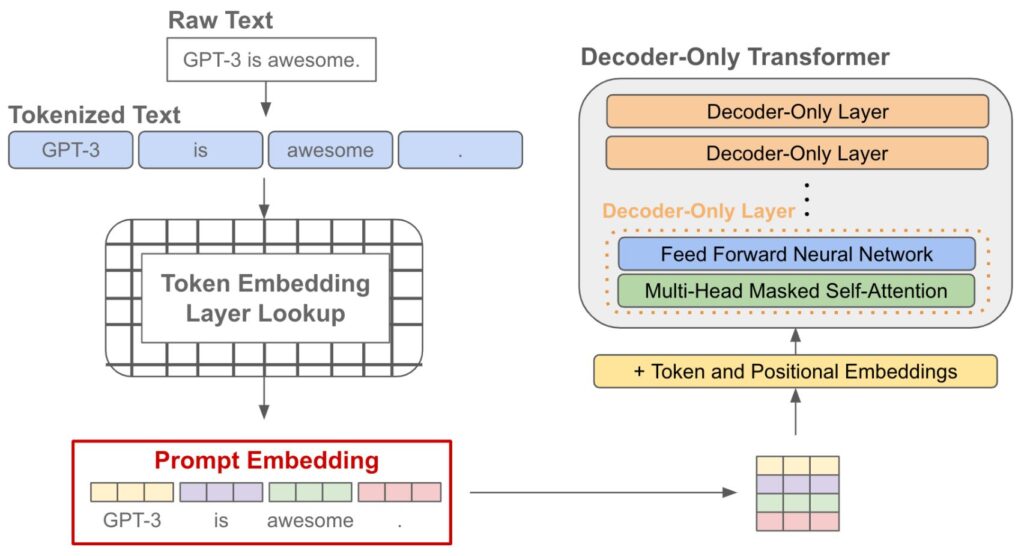

Kromě technik, které hledají lepší textové výzvy, existuje řada užitečných inženýrských prací, které prozkoumávají průběžné aktualizace pro rychlé vkládání. Nejprve bychom si měli připomenout, jaká okamžitá vložení jsou v rámci jazykového modelu. Vzhledem k textové výzvě obvykle tuto výzvu tokenizujeme (tj. rozdělíme ji na slova nebo podslova) a poté vyhledáme vložení každého výsledného tokenu. Tento proces nám poskytne seznam vložení tokenů (tj. rychlé vložení!), které předáme jako vstup do jazykového modelu;

„Promptování založené na gradientu“ je technika, která upravuje embeddingy výzvy (tj. reprezentace vstupního textu) namísto změny samotného textu výzvy. Tento přístup využívá metody jako gradientní sestup k iterativnímu zlepšení embeddingů výzvy a tím i výkonu modelu při plnění daného úkolu. Pojďme si přiblížit hlavní metody v této oblasti:

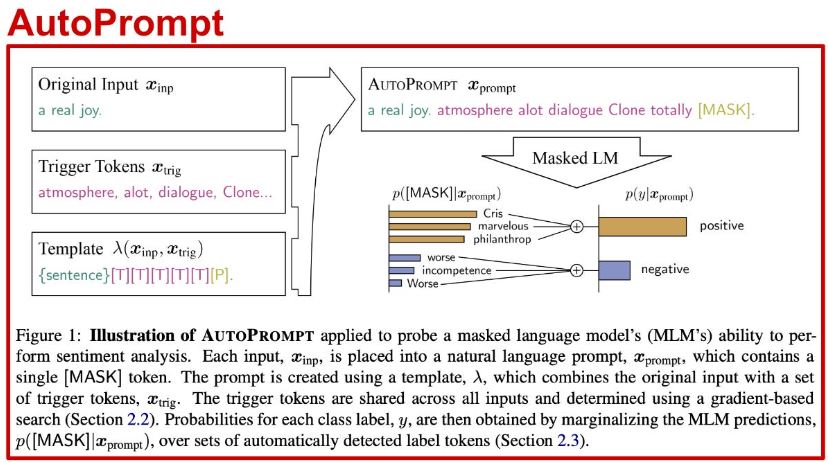

- AutoPrompt – Tato metoda přidává k původnímu vstupu sadu „spouštěcích tokenů“, které jsou stejné pro všechna vstupní data. Tyto tokeny jsou vybírány pomocí gradientního vyhledávání za účelem zlepšení výkonu modelu.

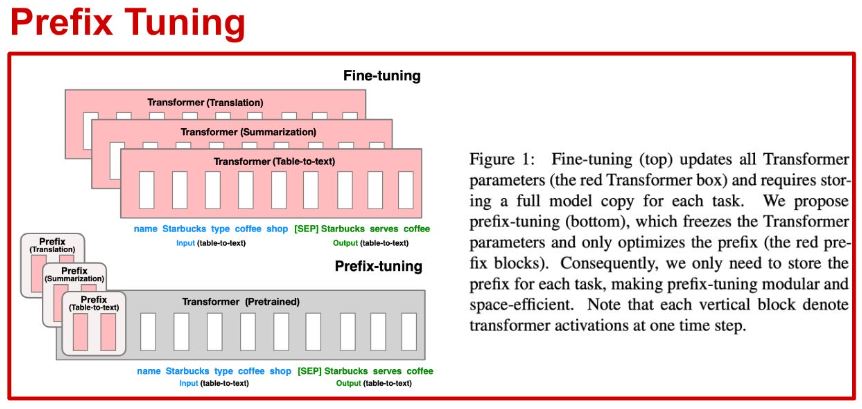

- Prefix Tuning – Přidává několik „prefixových“ tokenů ke vstupnímu promptu a do skrytých vrstev modelu. Parametry těchto prefixů jsou trénovány pomocí gradientního sestupu, zatímco parametry samotného modelu zůstávají fixní. Tento přístup umožňuje efektivní doladění modelu bez nutnosti modifikace jeho parametrů.

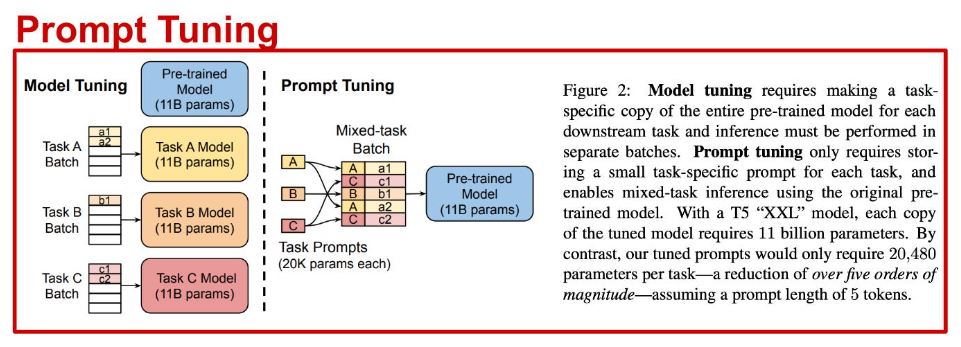

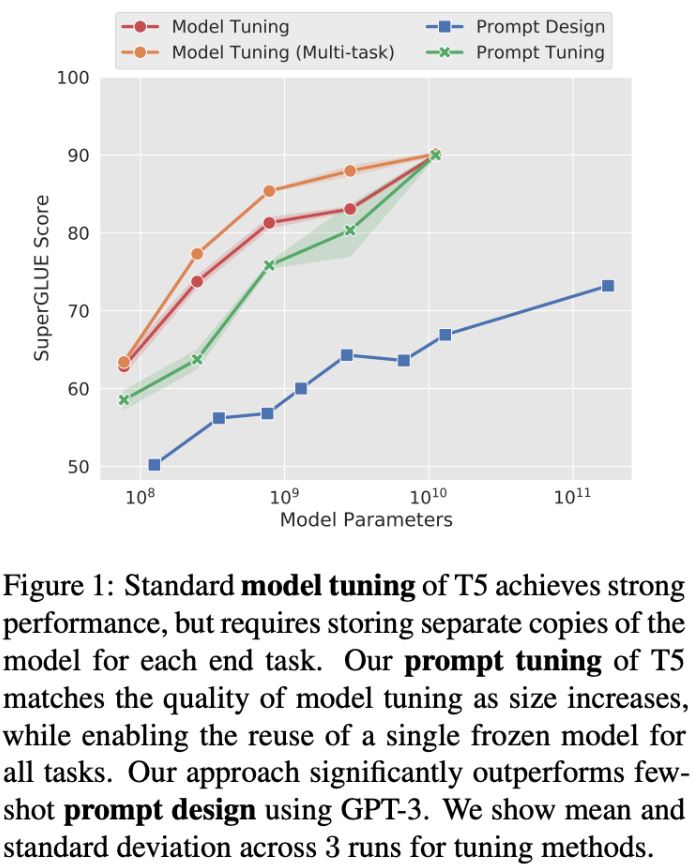

- Prompt Tuning – Podobné jako prefix tuning, ale prefixové tokeny se přidávají pouze do vstupní vrstvy modelu. Tyto tokeny jsou dolaďovány specificky pro každou úlohu, což umožňuje modelu lépe se přizpůsobit danému úkolu.

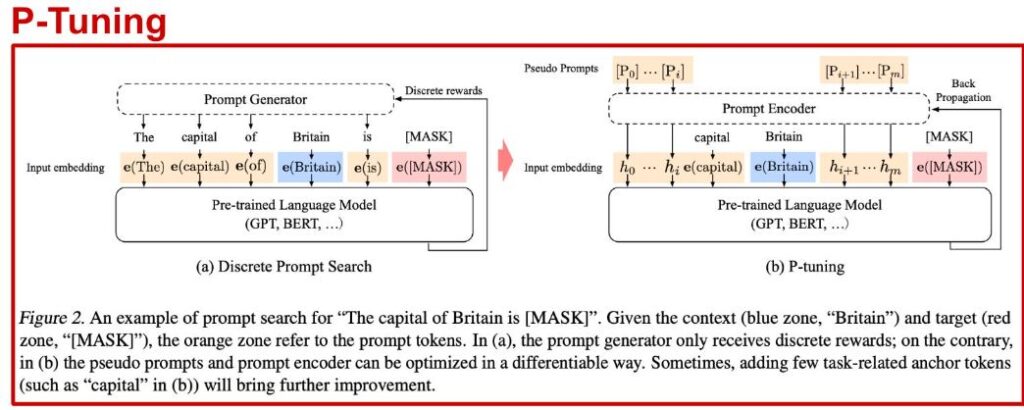

- P-Tuning – Tato metoda přidává specifické kotevní tokeny pro danou úlohu do vstupní vrstvy modelu. Tyto tokeny mohou být umístěny kdekoliv v promptu, například uprostřed, což poskytuje větší flexibilitu než prefix tuning.

Který z nich bychom měli použít?

- AutoPrompt je vhodný, pokud chcete rychle zlepšit výkon modelu bez rozsáhlého doladění.

- Prefix Tuning je efektivní, pokud potřebujete doladit model pro různé úkoly bez změny samotného modelu.

- Prompt Tuning je ideální, pokud je potřeba model přizpůsobit konkrétním úkolům.

- P-Tuning nabízí největší flexibilitu a je vhodný pro složitější scénáře, kde může být umístění kotevních tokenů kritické.

Pomocí Prompt Tuning stačí

i) přidat na vstup několik prefixových tokenů a

ii) provést parametricky efektivní jemné doladění těchto tokenů nad jednotlivými navazujícími úlohami.

Přístup na obrázku uvádí jemné ladění více úloh tak, že do každé aktualizace smíchá několik různých úloh a každé úloze přidělí jedinečný naučený prefix;

Přístup na obrázku uvádí jemné ladění více úloh tak, že do každé aktualizace smíchá několik různých úloh a každé úloze přidělí jedinečný naučený prefix. (Prefix tunning)

Obvykle by jemné doladění jazykového modelu znamenalo, že bychom museli pro každou úlohu ukládat samostatnou kopii parametrů modelu. Naproti tomu při ladění úloh se pouze doladí malá sada prefixových tokenů a ostatní parametry modelu zůstanou neměnné. Navzdory tomu, že se dolaďuje pouze malá skupina parametrů, se Prompt Tuning docela blíží výkonu end-to-end dolaďování, jak ukazuje obrázek.

Zdroj: https://cameronrwolfe.substack.com/p/advanced-prompt-engineering